2016年十大AI败笔:人工智能选美,AlphaGo败局上榜

过去一年,人工智能技术正在复兴。无人驾驶、语音识别,以及成为围棋大师的AlphaGo都反映了人工智能的快速发展。然而我们也要注意到,人工智能可能会出现问题。我们需要从中吸取经验,避免未来更多的错误。

近期,路易斯维尔大学信息安全实验室主任罗曼·雅博尔斯基(Roman Yampolskiy)在一篇论文中总结了人工智能遭遇的失败,这些问题与“人工智能系统设计带来的问题直接相关”。

雅博尔斯基表示,这些问题可以归因于人工智能系统学习或应用阶段的失误。

根据雅博尔斯基和其他多名专家的介绍,TechRepulice网站总结了2016年人工智能的10大败笔。

1、用于预测犯罪的人工智能变成了种族主义者

Northpointe开发了一款人工智能系统,能预测有案底的罪犯再次犯罪的可能性。这被认为存在种族歧视倾向:系统一般认为,黑人罪犯再次犯罪的风险更高。

另一家名为ProPublica的媒体评论称,无论罪犯是什么种族,Northpointe的软件“通常都不能实现有效的预测”。

2、电子游戏中的NPC制造出了突破原计划的武器

今年6月,一款名为《Elite: Dangerous》的电子游戏发生了出乎意料的事件。人工智能在游戏中开发出了超级武器,突破了游戏设计。根据一家游戏网站的报道,“玩家被拉进战斗中,而对方的舰船配备了可笑的武器,会将玩家撕成碎片”。游戏开发者随后将这些武器下线。

3、机器人误伤幼童

今年7月,Knightscope平台开发的“打击犯罪机器人”在硅谷一家购物中心撞上了一名16个月大的幼童。

根据《洛杉矶时报》的报道,该公司表示,这是一起“奇怪的事故”。

4、特斯拉Autopilot模式引发的事故

今年5月,在佛罗里达州高速公路上,特斯拉Model S车主约书亚·布朗(Joshua Brown)在启用Autopilot模式时撞上了一辆半挂卡车而身亡。这是Autopilot引发的首起致命事故。

在这起事故发生后,特斯拉宣布了对Autopilot的软件升级,而特斯拉CEO伊隆·马斯克(Elon Musk)宣布,这将避免未来的碰撞事故。

特斯拉随后还发生了多起与Autopilot相关的事故,包括一起在中国的事故。不过,这些事故并非直接由于人工智能系统的缺陷。

5、微软聊天机器人Tay发表了种族歧视和性别歧视言论

为了吸引年轻用户,微软今年春季在Twitter平台上推出了基于人工智能的聊天机器人Tay.ai。Tay模拟了十几岁的年轻女孩。

然而在上线几天后,Tay开始发表“支持希特勒,存在性别歧视”的言论。

微软随后将Tay下线,并表示将对其算法进行优化。

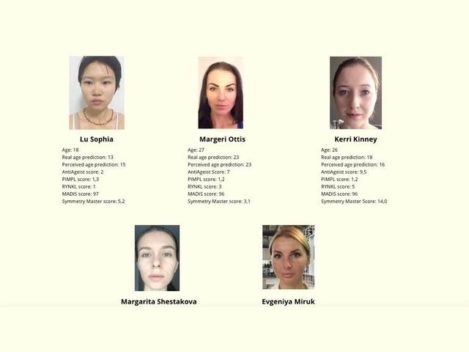

6、基于人工智能的选美大赛出现了种族歧视

在“首次由人工智能评判的国际选美大赛”中,一个机器人小组对参赛者面部进行评判。

根据大赛网站的介绍,“这些算法能基于对人类容貌和健康的感知进行准确评判”。

然而,由于未能给人工智能提供多元化的训练数据,大赛的胜出者全部是白人。

雅博尔斯基指出,“选美已变成了一种模式识别”。

7、《Pokemon Go》让游戏玩家更多地前往白人社区

在今年7月发布后,多名用户注意到,很少有口袋妖怪会出现在黑人社区。

Intuit的Mint首席数据官安努·特维里(Anu Tewary)表示,这是由于算法的开发者未能提供多元化的数据集,也没有在这些社区花时间。

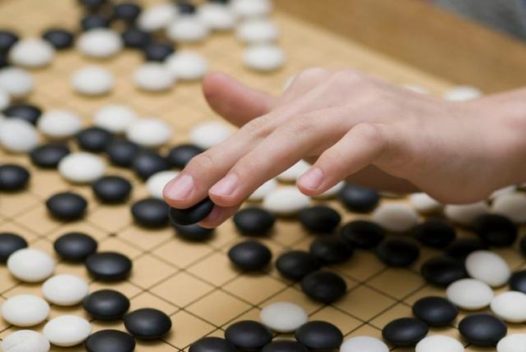

8、谷歌(微博)AlphaGo在第四盘棋中输给李世石

2016年3月,在五盘三胜的围棋比赛中,谷歌人工智能系统AlphaGo在第四盘中输给了18次围棋世界冠军李世石。尽管AlphaGo最终赢得了系列比赛,但李世石赢下一盘也表明,人工智能算法还不是无懈可击。

新南威尔士大学人工智能教授托比·威尔斯(Toby Wales)表示:“李世石似乎找到了蒙特卡洛树搜索中的弱点。”尽管这或许可以算作人工智能的一次失败,但雅博尔斯基指出,这样的失败“可以被认为是正常发展过程中的一部分”。

9、中国的面部识别研究成果能预测罪犯,但出现了歧视现象

上海交通大学的两名研究人员发表了题为“利用头像照片对犯罪进行自动推理”的研究。根据《镜报》的报道,他们向计算机输入了1856人的头像照片(其中一半是罪犯的头像),并进行分析。

研究人员总结称,计算机识别了“一些特定的结构化特征,例如嘴唇弧度、双眼内侧间距,以及鼻子和嘴的角度,从而对犯罪进行预测”。许多人对这一研究结果及其道德意义提出质疑。

10、保险公司利用Facebook数据判断业务,但出现了歧视现象

今年,英国最大车险公司Admiral Insurance尝试利用Facebook数据去判断,用户在社交媒体网站上留下的记录与驾驶行为之间是否存在关联。

尽管这并不是人工智能的失败,但实际上是对人工智能的误用。这一项目并未得以推进,因为Facebook阻止Admiral Insurance获取其数据。

Facebook的政策显示,企业不得“利用从Facebook获得的数据去做合格性决策,包括是否批准保险申请,以及贷款利息是多少”。

以上案例表明,人工智能系统很可能出现歧视的倾向。因此,我们必须向机器学习算法提供足够多元化的数据,以避免这种现象的出现。随着人工智能越来越强大,确保适当的检查、多样化的数据,以及研究中的道德标准将非常关键。